|  |  |  | | NUMERO 1317 |  |

|  |

|  |  | | Edition du 04 Juillet 2025 |

| |

|

| Edito

Les énergies marines montent en puissance

Je vais évoquer cette semaine les immenses potentialités de trois des principales énergies marines, marémotrice (énergie des marées), hydrolienne (énergie des courants marins) et houlomotrice (énergie des vagues), dont les dernières estimations montrent qu'elles pourraient, en théorie, fournir à toute l'humanité l'électricité dont elle aura besoin en 2050, soit environ 46 000 TWh par an. Après être restées pendant des décennies des curiosités de laboratoires, ces formes d'énergies, au potentiel considérable, mais techniquement complexes à utiliser de manière efficace et rentable, sont enfin en train d'arriver à maturité et pourraient contribuer de manière conséquente et décisive au mix énergétique mondial décarboné que nous devrions atteindre en 2050. LR 17;énergie marémotrice, parfaitement prévisible, représente un potentiel mondial d'environ 400 TWh par (l'équivalent de la consommation électrique de la France) et de 25 TWh pour notre pays (2 fois l'EPR de Flamanville). En France, l’usine marémotrice de La Rance en Bretagne, inaugurée en 1966 par le Général de Gaulle, fonctionne parfaitement depuis près de 60 ans et est restée longtemps la plus puissante au monde. Cette remarquable installation, qui n'a cessé d'être modernisée, fournit environ 5 TWh par an, de quoi alimenter en électricité une ville comme Rennes (240 000 habitants). Les projets d’usines marémotrices restent malheureusement trop rares, principalement pour deux raisons, leur coût et leur impact environnemental. Lors de la construction de l'usine de la Rance, l’estuaire de la mer a dû être coupé pendant trois ans. Mais les technologies ont beaucoup évolué et il est aujourd’hui possible de construire des lagons artificiels qui permettent d'implanter ces centrales marémotrices loin des côtes. Ces nouvelles installations peuvent également s’inscrire dans des projets plus vastes d’aménagement du territoire et de protection des côtes contre les tempêtes et l'élévation du niveau des mers. Un projet de lagon marémoteur géant a été proposé il y a plus de vingt ans dans la baie de Swansea, au Pays de Galles. Après de nombreuses péripéties, ce projet, qui comporte 25 km de digues, a été relancé récemment par le gouvernement britannique. Un autre projet, bien plus ambitieux est également à l'étude. Il consiste en une usine marémotrice de nouvelle génération pour exploiter la rivière Mers ey, qui traverse Liverpool et se jette en Mer d'Irlande. Cette centrale hors-norme se composerait de 28 turbines, exploitant des différences de hauteur d’eau qui peuvent atteindre les 10 mètres. L’usine de 700 mégawatts (MW) serait capable de produire de l’électricité à marée montante et à marée descendante. Elle deviendrait ainsi la plus grande du monde et elle pourrait alimenter plus d’un million de foyers. Dans ce cas de figure, l’option retenue n’est pas celle du lagon artificiel au large, qui aurait un coût jugé trop élevé. Les ingénieurs imaginent plutôt un large barrage sur la rivière, le Mersey Tidal Power. Cette structure géante permettrait de créer un lien cyclable et piétonnier sur la rivière et de relier Liverpool et la péninsule de Wirral. Autre avantage majeur, elle pourrait également protéger cette importante métropole de 500 000 habitants contre les inondations, dont les risques pourraient être multipliés par dix d'ici la fin du siècle, à cause du réchauffement climatique et de l’élévation du niveau des mers. Cette mégastructure permettrait également le maintien du trafic fluvial, grâce à l’intégration de plusieurs écluses. S'agissant de la rentabilité économique, compte tenu de la durée d'exploitation d'une telle installation – plus d'un siècle, avec un entretien adapté – les experts tablent sur un prix moyen de revient de l’électricité produite très compétitif, de l'ordre de 70 €/MWh. Une centrale marémotrice fonctionne sur le principe des phases de turbinage, au flux et au reflux de la marée, alternées par de courtes périodes d’attente afin de retrouver la hauteur de chute suffisante entre l’intérieur et l’extérieur du bassin. Le rendement et la rentabilité de ces installations peuvent en outre être améliorés, en utilisant les turbines pour pomper de l’eau à la fin de chaque phase de remplissage et de vidange du bassin afin d'augmenter la hauteur de chute et de prolonger ainsi la durée de la production d’électricité. Ce procédé est d'autant plus intéressant que l’énergie requise pour le pompage est plus que compensée par la production supplémentaire, qui est de l'ordre de 10 %. Ce système présente par ailleurs un avantage environnemental important car il permet de mieux prot éger les écosystèmes, en rétablissant les niveaux naturels de la marée au sein du bassin. Un lagon marémoteur autorise également la modulation de la production électrique, en fonction de la fluctuation des besoins du réseau en temps réel. Dans ce cas de figure, il devient comparable à une STEP (station de transfert d’énergie par pompage). Moins connue et moins mature que l'énergie des marées, l'énergie hydrolienne, qui consiste à exploiter les courants marins, a également un potentiel immense, de l'ordre de 17 500 TWh par an, soit plus de la moitié de la consommation mondiale d’électricité. Dans le Nord-Cotentin, deux projets conséquents dans le Raz Blanchard, connu pour ses forts courants marins, viennent de recevoir l’appui de l’Europe. Dans un premier temps, ils prévoient d’immerger une dizaine de turbines à plus de 30 m de profondeur d’ici à 2028, puis une centaine à terme. Le premier projet, porté par Normandie Hydroliennes, s'appelle NH1 et compte quatre turbines de 3 MW. Celles-ci devraient produire, à partir de 2028, 34 GWh par an d'énergie propre, durable et prévisible au réseau national français, de quoi approvisionner 15 000 habitants. La techn ologie déployée sera la turbine à axe horizontal série AR développée par Proteus. L'autre projet est Flowatt, qui compte six turbines de 2,5 MW. Ce projet, avec ses six hydroliennes pour une capacité totale de 17 mégawatts (MW), pourra alimenter 20 000 personnes en électricité. Le projet, porté par HydroQuest et Qair, a reçu une aide significative de 65 millions d’euros dans le cadre du plan France 2030. Selon le Syndicat des énergies renouvelables (SER), les coûts de production de cette énergie hydrolienne pourraient chuter sous les 100 euros/MWh pour le premier gigawatt installé, puis atteindre moins de 80 euros/MWh, se rapprochant des coûts de production de l'énergie par l'éolien marin. Le turbiner britannique Proteus Marine Renewables, déjà impliqué dans le projet de ferme NH1 au Raz Blanchard, vient également d’immerger avec succès, après un an d’essais concluants, son prototype d’hydrolienne gravitaire AR1100, d’une puissance de 1,1 MW, dans le détroit de Naru, au Japon. L’hydrolienne AR1100 est équipée d’un dispositif qui transmet l’énergie mécanique du rotor vers un générateur à aimant permanent. L’électricité ainsi produite est acheminée vers la côte, via un câble sous-marin qui devrait permettre d’alimenter l’archipel de Goto. En 2024, le Forum économique mondial (WFO) a pris acte du potentiel de la troisième forme d'énergie des mers que je voulais évoquer, l’énergie des vagues, encore appelée énergie houlomotrice. L'Irena, l’Agence internationale pour les énergies renouvelables, souligne que de toutes les énergies marines, l'énergie des vagues est, de loin, celle qui offre le potentiel le plus prometteur. Il serait en effet de l'ordre de 29 500 TWh (térawattheures) par an, soit l'équivalent de la consommation mondiale d'électricité en 2022. Rappelons que l’Europe vise à atteindre une capacité de production d’énergie houlomotrice d'un GW à l’horizon 2030. Les ingénieurs ont imaginé et testé de nombreux dispositifs pour capter et convertir la puissante énergie cinétique des vagues en électricité. Mais la plupart des technologies développées n'atteignent pas la fiabilité de fonctionnent et la longévité suffisante, car elles doivent affronter des contraintes physiques, chimiques et mécaniques redoutables. De ce fait, l’énergie houlomotrice reste marginale, par rapport aux autres sources d’énergie renouvelable. Pour essayer de surmonter ce défi, des chercheurs gallois ont travaillé pour exploiter l’interaction entre deux types de vagues : celles qui se trouvent à la surface de l’océan et celles qui évoluent sous l’eau. Le Professeur Kardi, de l'université de Cardiff, a montré, dans un article remarqué, comment les ondes sonores sous-marines peuvent être utilisées pour rendre les ondes de surface plus puissantes, ce qui pourrait en faire une source d’énergie plus viable. Les vagues à la surface de l’océan sont souvent créées par la combinaison du vent qui soulève l’eau et de la gravité qui la ramène vers le bas – c’est pourquoi on les appelle aussi « vagues de gravité de surface ». En revanche, les ondes sous-marines sont des ondes sonores produites par des phénomènes tels que les tremblements de terre ou les éruptions volcaniques, qui trouvent leurs origines à de grandes profondeurs. Ces ondes acoustiques se déplacent en comprimant et en dilatant l’eau, de la même manière que le son se déplace dans l’air. Elles peuvent traverser mers et océans à la vitesse du son dans l’eau (environ 1 500 mètres par seconde) avant de se dissiper. Les ondes de surface, en revanche, se déplacent à des vitesses beaucoup plus faibles, de l’ordre de quelques dizaines de mètres par seconde. Ces chercheurs gallois ont montré qu'en fait ces deux types de vagues interagissaient dans un phénomène connu sous le nom de "résonance triadique". Selon ces scientifiques, il est possible d'utiliser un générateur d’ondes acoustiques pour produire des ondes sonores accordées à une taille et à une fréquence particulière qui renforcerait, ou annulerait, les ondes de surface. L’amélioration des vagues permettrait aux turbines houlomotrices de produire davantage d’électricité (Voir Research Gate). En Suède, le Docteur Stig Lundbäck, cardiologue, a conçu une étonnante bouée houlomotrice, en s'inspirant du fonctionnement du cœur humain, pour pomper le sang. Ce scientifique a fondé la société CorPower Ocean qui a développé le “CorPack”, une bouée géante de 7 tonnes, mesurant 9 mètres de diamètre pour 19 mètres de haut. Elle est fabriquée à partir de matériaux durables et légers et convertit le mouvement des vagues en électricité. Comme le fait la pression hydraulique utilisée par le cœur pour pomper le sang dans une direction, CorPack fonctionne en appliquant une tension sur lui-même pour tirer la bouée vers le bas, tandis que les vagues la poussent vers le haut. Le mouvement des vagues est transformé en rotation, qui est ensuite convertie en électricité par des générateurs. L'ingénieux mécanisme de ce convertisseur d'énergie houlomotrice permet d'extraire l'énergie des vagues de manière particulièrement efficiente, à l'aide d'un dispositif peu coûteux. En termes de rendement, ce convertisseur serait capable, selon ses concepteurs, de produire de cinq fois plus d'électricité par tonne d'équipement que ses concurrents directs (Voir Offshore Energy). Au Portugal, la société Eco Wave Power, qui exploite depuis une dizaine d'années l'énergie des vagues, va pour la première fois créer une installation houlomotrice d'un mégawatt de puissance. C'est la ville de Porto qui accueillera cette structure, qui intégrera un équipement de conversion d’énergie sous le brise-lames de Porto, dans une galerie qui sera ouverte au public et abritera un musée consacré à l'énergie des vagues. Cette centrale houlomotrice disposera à terme d'une puissance maximale de 20 MW. Dans ce système, chaque flotteur est monté sur un piston qui se tend et se détend selon le rythme de la houle. Ce mouvement fait circuler un fluide hydraulique à l'intérieur d'un circuit fermé et ce fluide alimente un rotor hydraulique qui produit de l'électricité. En France, un projet similaire de digue houlomotrice est en cours. Ce projet, baptisé Dikwe, est porté par le groupe Legendre, en collaboration avec l'Ifremer et Geps Tehno. Lauréat des Trophées Innovation Océana 2024, Dikwe a atteint une efficacité de 40 % lors des tests, ce qui est remarquable pour une installation de ce type. L'originalité de ce système réside dans le fait qu'il permet d’intégrer un dispositif de récupération de l’énergie des vagues dans les infrastructures portuaires et combine de manière ingénieuse protection côtière et production d’électricité. Le dispositif développé repose sur une structure hybride composée de béton armé, d’acier et de bois, intégrant un mécanisme de volets oscillants. Ces volets, actionnés par les vagues, génèrent de l’électricit& eacute; en exploitant la force des mouvements marins. Cette approche permet de rentabiliser les infrastructures existantes en s’intégrant à la structure de la digue et en transformant l’énergie mécanique des vagues en électricité. Après des tests concluants en bassin, un prototype à l’échelle 1/4 de cette digue a été immergé pendant plusieurs mois en rade de Brest, à Saint-Anne-de-Portzic (29). La construction d’un démonstrateur à taille réelle est à présent envisagée dans les mois qui viennent (Voir Offshore Energy). En novembre dernier, EcoWave Power a obtenu les autorisations nécessaires pour réaliser dans le port de Los Angeles, en coopération avec  ;All-Ways Metal, Inc, la première centrale à énergie houlomotrice aux États-Unis. En Grande Bretagne, la firme Spiralis Energy a développé l’Axial Skelter, une étonnante turbine en forme de spirale, qui permet une exploitation durable et efficace des courants marins et fluviaux et a donné des résultats prometteurs pendant les essais. La forme hélicoïdale de cette turbine s'inspire des coquillages marins et permet une résistance et une durabilité accrues. Conçu à partir de plastiques recyclés par impression 3D, ce dispositif se distingue par son faible coût de production et d'exploitation. Chaque unité, prévue pour durer 25 ans en milieu marin, n'a qu'un faible impact sur la biodiversité, contrairement aux turbines à pales traditionnelles. Lors des essais de 2024, l’Axial Skelter a atteint 2 500 watts avec 21 rotations par minute. La version grandeur nature, de 16 mètres de long et 5 mètres de diamètre, dével oppera une puissance de 250 kilowatts (kW). Ce système simple (une seule pièce mobile sous l'eau), robuste et modulaire, pourrait avoir de nombreuses applications, comme l’alimentation de centres de données ou la production d’hydrogène (Voir International Water Power). Le CETO est un système innovant de conversion d’énergie des vagues entièrement immergé. Mis au point par la firme irlandaise CETO Wave Energy Ireland, ce générateur a fait ses preuves lors d'essais au large du Pays basque, en Espagne. Le CETO est considéré comme l'un des systèmes les plus avancés au monde. Il a été conçu pour être immergé à quelques mètres sous la surface et peut s’adapter à différents types d’environnements marins. Ce dispositif prend la forme d'une grosse bouée, amarrée au fond de la mer, qui flotte dans l’eau et suit le mouvement des vagues. Il est possible d’installer plusieurs modules sur le même site, pour accroître, si besoin, la production d'énergie. L’énergie électrique générée est transportée par câble vers la terre ferme (Voir TCD). Je voudrais évoquer enfin le convertisseur houlomoteur mis au point par la société bordelaise Seaturns. Ce dernier vient d'être testé avec succès, en collaboration avec l'Ifremer pendant 18 mois, à Sainte-Anne-du-Portzic, dans la rade de Brest (Finistère). Il utilise une technologie innovante, reposant sur un flotteur rempli d’air et d’eau douce. Sous l’effet de la houle, les masses d’eau douce poussent de l’air à travers une turbine qui produit de l’électricité en tournant. Comme le souligne Vincent Tournerie, dirigeant de Seaturns, « Notre système simple et robuste a été conçu pour résister aux conditions les plus hostiles ». Et, de fait, le prototype testé a bien résisté aux assauts de la tempête Ciaran. Un prototype de taille réelle va être installé au lar ge de Pornic (Loire-Atlantique) à partir de juillet 2025. Une unité peut alimenter en électricité une dizaine de foyers, mais l’entreprise souhaite développer des parcs d’une dizaine de flotteurs minimum, pour une production d’électricité évaluée à 2 MWh. A ces trois énergies marines, marémotrice, hydrolienne et houlomotrice, il faudrait ajouter l'énergie thermique des mers (ETM), qui dispose également d'un potentiel exploitable mondial considérable (de l'ordre de 10 000 TWh par an). Mais les recherches sur l'ETM sont malheureusement beaucoup moins actives et avancées que celles concernant les trois formes d'énergie marine que j'ai évoquées et l'ETM n'est en outre rentable qu'en exploitation dans certaines zones tropicales (compte tenu des contraintes d'efficacité thermodynamique), ce qui en limite les possibilités de développement à l'échelle de la planète. Néanmoins, un prototype pour convertir l’énergie thermique des océans est à l'essai depuis mars 2024 dans les îles Canaries, dans le cadre du projet énergétique PLOTEC, financé par l’Union européenne. On le voit, les principales énergies marines, qui arrivent enfin à maturité technique, sont appelées à jouer un rôle important pour accélérer la décarbonatation du mix énergétique mondial, en coproduisant électricité et hydrogène propres. Certes, l'utilisation de ces énergies demande d'importants investissements, mais, contrairement au soleil et au vent, ces énergies ont l'avantage d'être prévisibles, un atout précieux pour atteindre d'ici 2050 le seuil de rentabilité en terme de coût de production de l'électricité propre. Désormais, il n'est plus utopique d'imaginer que ces énergies marines puissent enfin se développer à grande échelle partout dans le monde et permettent, en association avec le solaire, l'éolien, l'énergie hydraulique et le nucléaire, de gagner de pr&ea cute;cieuses années dans le basculement vers un mix électrique mondial sans énergies fossiles. Il va de soi que la France, avec ses trois façades maritimes et ses compétences humaines et technologiques reconnues dans ce domaine d'avenir, a une place majeure à jouer dans cette compétition technique et industrielle mondiale, où rien n'est encore joué... René TRÉGOUËT Sénateur honoraire Fondateur du Groupe de Prospective du Sénat e-mail : tregouet@gmail.com

|  |

|  |  | | TIC |  |

Information et Communication |  |

|  | | |  |  |

La réparation de l’ADN est un processus complexe et fascinant qui joue un rôle crucial dans la préservation de l’intégrité génétique de nos cellules. Grâce aux avancées technologiques, les chercheurs ont désormais la capacité de percer les mystères de cette machinerie moléculaire, notamment grâce aux supercalculateurs. Le supercalculateur Summit a permis de mettre en lumière comment les brins d’ADN endommagés sont réparés par un processus appelé réparation par excision de nucléotides (NER). Cette découverte ouvre la voie à de nouvelles perspectives pour le traitement de maladies génétiques et de certains cancers. La réparation par excision de nucléotides (NER) est un mécanisme essentiel qui corrige une large variété de dommages sur l’ADN. Ce processus, en trois étapes, utilise une machinerie moléculaire délicatement équilibrée pour identifier et réparer les lésions. Selon Ivaylo Ivanov, professeur de chimie à l’Université d’État de Géorgie, cette voie est essentielle pour comprendre comment les cellules réparent leur matériel génétique. Cependant, des mutations nocives peuvent perturber ce mécanisme et provoquer des maladies humaines graves. Ivanov a souligné que les effets des mutations génétiques varient en fonction de leur position au sein des complexes de réparation. Ainsi, comprendre les interactions dans le NER pourrait potentiellement aider à développer de nouveaux traitements po ur des maladies telles que le cancer, qui résultent souvent de dommages non réparés au niveau de l’ADN. Pour étudier le complexe de pré-incision (PInC), un élément clé du NER, les scientifiques ont utilisé NAMD (Nanoscale Molecular Dynamics), un code de dynamique moléculaire conçu pour les supercalculateurs. La puissance de calcul du Summit, capable d’effectuer 200 000 milliards de calculs par seconde, a été cruciale pour comprendre les dynamiques fonctionnelles du complexe PInC à l’échelle des microsecondes. Les simulations ont révélé comment les différentes composantes du NER interagissent et se subdivisent en communautés dynamiques, formant les parties mobiles de cette machinerie complexe. Cela a permis d’identifier les régions critiques où des mutations peuvent interférer avec le fonctionnement du complexe NER, offrant ainsi une meilleure compréhension des désordres qui en découlent. Le NER se déroule en trois étapes distinctes : la reconnaissance, la vérification et la réparation. Chaque étape nécessite des groupes spécifiques de protéines pour accomplir des fonctions particulières. Par exemple, la protéine XPC agit comme un premier intervenant qui localise le site de l’ADN endommagé et modifie la structure de l’hélice pour rendre le dommage accessible. Des mutations dans les protéines XPF et XPG peuvent entraîner des troubles génétiques sévères, tels que le xeroderma pigmentosum et le syndrome de Cockayne. Ces conditions peuvent rendre les individus plus sensibles au cancer de la peau et affecter leur croissance et développement. Comprendre ces mutations et leur impact sur le NER est essentiel pour développer des interventions thérapeutiques efficaces. Bien que la majorité des simulations moléculaires aient été réalisées sur Summit, ce supercalculateur a pris sa retraite fin 2024. Les chercheurs se tournent désormais vers Frontier, le supercalculateur exascale qui a vu le jour en 2022, pour poursuivre leurs travaux. L’équipe prévoit d’examiner le NER couplé à la transcription, un processus de réparation de l’ADN qui corrige les dommages dans les gènes activement transcrits, garantissant ainsi la production continue de protéines essentielles. Ces avancées ouvrent de nouvelles perspectives pour la recherche biomédicale, en offrant un aperçu détaillé des mécanismes de réparation de l’ADN. Enviro2B du 01.06.2025 : https://www.enviro2b.com/2025/06/01/elle-fait-200-000-milliards-de-calculs-par-s... |  | | ^ Haut |  |

|

|  | | Avenir |  |

Nanotechnologies et Robotique |  |

|  | | |  |  |

La start-up suisse Rivr, spécialisée dans la robotique, lance ses premiers robots-chiens à travers deux programmes expérimentaux en Angleterre et aux États-Unis, avec des plates-formes locales de livraison de colis. Ces collaborations visent à optimiser la livraison dite du dernier kilomètre. Ces robots sont spécialement conçus pour naviguer dans des environnements urbains variés. Ils sont par exemple capables de monter et descendre des escaliers, mais aussi d'avancer sur des terrains irréguliers. Contrairement à d'autres solutions qui s'arrêtent au niveau du trottoir, ces robots peuvent en théorie livrer directement à la porte du client, en travaillant en tandem avec un agent humain. Les deux premiers programmes mis en place, à Barnsley en Angleterre et à Austin aux États-Unis, ont comme objectif de tester l'intégration de ce type de robot dans les opérations de livraison afin de répondre aux défis croissants du e-commerce. L'idée est de pouvoir collecter suffisamment de données pour en faire circuler une centaine d'ici l'année prochaine. Le robot, baptisé Rivr One, est parfaitement autonome, doté d'une architecture hybride combinant des roues et des jambes, ce qui lui permet de naviguer efficacement dans des environnements très variés jusqu'à la porte du client. Doté d'une savante combinaison de capteurs (caméras, LiDAR, caméras) et alimenté par de l'intelligence artificielle, il a été entraîné à une multitude de situations, ce qui lui permet de s'adapter en temps réel à son environnement. Aujourd'hui, il peut transporter des charges allant jusqu'à 30 kg et peut fonctionner de jour comme de nuit. Outre la livraison de colis, ce robot-chien pourrait un jour livrer des repas ou bien encore représenter une aide logistique en entreprise pour faciliter le transport de documents ou d'équipements importants. D'ordinaire, les robots de livraison se présentent sous une forme plus conventionnelle de petits chariots fermés roulant, venant déposer des denrées alimentaires ou des petites marchandises à la porte de leurs clients. Rien qu'aux États-Unis, depuis plusieurs années, les livraisons effectuées par des robots se multiplient, notamment dans les universités américaines. En dehors des États-Unis, ce service commence aussi à se développer en Grande-Bretagne, en Allemagne, au Danemark et en Estonie. La Dépêche : https://www.ladepeche.fr/2025/06/02/bientot-des-robots-chiens-pour-venir-vous-li... |  | | ^ Haut |  |

|

|  | | Matière |  |

Matière et Energie |  |

|  | | |  |  |

Une équipe de chercheurs internationaux en Arabie saoudite a mis au point un nouveau matériau composite à base d’acrylate qui améliore les performances des cellules solaires. L’adhésion du matériau composite aux cellules solaires déployées en Arabie saoudite pendant des semaines a considérablement augmenté la puissance et la longévité tout en réduisant l’électricité consommée par les cellules. L’énergie solaire est un objectif stratégique majeur pour les économies vertes dans de nombreux pays, et plus des trois quarts des installations renouvelables sont des cellules solaires Mais une énergie solaire fiable et durable s’accompagne de défis majeurs. Les panneaux solaires commerciaux convertissent environ 20 % des rayons du soleil en électricité. Le reste est absorbé sous forme de chaleur ou réfléchi. De plus, la chaleur réduit les performances et la durée de vie des cellules solaires, ce qui signifie qu’elles doivent être remplacées plus tôt que prévu. Il est donc nécessaire de refroidir les cellules solaires, mais les systèmes de refroidissement tels que les ventilateurs et les pompes nécessitent de l’électricité. Le refroidissement passif, en revanche, n’en a pas besoin. « Nous sommes sp&eac ute;cialisés dans les matériaux qui permettent un refroidissement passif. Ces matériaux sont minces et peuvent être placés sur différents systèmes qui nécessitent un refroidissement pour fonctionner, comme les serres et les cellules solaires, sans affecter les performances », a déclaré Qiaoqiang Gan, professeur à l’université KAUST, qui a dirigé l’étude. Dans cette nouvelle étude, réalisée par le Centre d’excellence pour les énergies renouvelables et les technologies de stockage du KAUST, M. Gan et ses collègues ont préparé un composite hydroscopique composé de chlorure de lithium et de polyacrylate de sodium qui absorbe l’humidité de l’air pendant la nuit et la libère pendant la journée. Le polyacrylate est un polymère bon marché, et le processus de fabrication ne nécessite pas de produits chimiques hostiles ou de réactifs spécialisés, contrairement à d’autres composites hydroscopiques utilisés pour le refroidissement, ce qui réduit encore le coût. Lors de leur fonctionnement pendant des semaines dans le désert saoudien, les cellules solaires auxquelles adhérait ce matériau étaient 9,4°C plus froides que celles qui en étaient dépourvues. Elles ont également augmenté leur puissance de plus de 12 % et leur durée de vie de plus de 200 %, tout en réduisant leur coût de production d’électricité de près de 20 %. Outre l’Arabie saoudite, des expériences ont été menées dans certaines des régions les plus fraîches des États-Unis continentaux, sous la pluie, afin de prouver que la technologie de refroidissement passif fonctionne dans n’importe quel environnement. Science Direct : https://www.sciencedirect.com/science/article/abs/pii/S0927796X25000932?via%3Dih... |  |  |  |

| |  |  |

L’Agence américaine pour les projets de recherche avancée de défense (DARPA), dans le cadre du programme POWER (pour Persistent Optical Wireless Energy Relay), tente de mettre au point un moyen de transmettre de l'électricité à l’aide d’un faisceau laser. À l’avenir, cela pourrait prendre la forme d’un véritable réseau sans fil, capable d’alimenter en continu des équipements militaires, drones, capteurs ou infrastructures critiques et éliminer les besoins en carburant. À l'issue de leurs derniers tests, les chercheurs semblent avoir établi un record : une livraison de plus de 800 watts à une distance de 8,6 kilomètres pendant une transmission laser de 30 secondes. La technologie sur laquelle s'appuient les chercheurs s’appelle la "transmission optique d’énergie". Elle consiste à convertir de l’électricité en un faisceau lumineux (laser) qui transporte cette énergie à distance. À l’arrivée, ce faisceau est capté par un récepteur qui reconvertit la lumière en électricité utilisable grâce à des cellules photovoltaïques. Depuis plusieurs décennies, des chercheurs se penchent sur cette approche, sans que celle-ci ne dépasse le stade expérimental. Mais cela pourrait bientôt changer, au vu des derniers résultats du projet POWER. Comme l’explique Interesting Engineering, les chercheurs ont démontré le succès d’un système de transmission d’énergie laser au sol appelé PRAD (pour Power Receiver Array Demo). Cet outil transmet un faisceau laser en le faisant passer à travers la couche atmosphérique la plus proche du sol, là où l’air est le plus dense et chargé de particules. Son récepteur capte la lumière laser avec un minimum de perte, puis un miroir parabolique la dirige vers des cellules photovoltaïques qui la convertissent en électricité utilisable. Ainsi, les chercheurs ont pu prouver que la transmission avait fonctionné, même sous l’impact maximal des effets atmosphériques. Avec cette démonstration, les chercheurs poussent la communauté scientifique à repenser sa manière de considérer la transmission optique d’énergie. Alors que les opérations militaires dépendent entièrement de l’électricité, cette technologie pourrait permettre d’en livrer rapidement dans des lieux isolés, sur des champs de bataille ou dans des zones sinistrées. Les appareils sur place pourraient être directement ravitaillés en électricité, ce qui engendrerait une réduction drastique des besoins en carburant et des risques logistiques liés à son transport. Parmi les applications concrètes envisagées, les drones occupent une place centrale : ils pourraient recevoir de l’énergie par laser en plein vol, sans être obligés de se poser pour être rechargés ou faire le plein, ce qui prolongerait considérablement leur autonomie et leur efficacité opérationnelle. Pour permettre cela, la DARPA se concentre désormais sur la phase 2 du programme, visant à démontrer la possibilité d’une transmission verticale d’électricité via des relais aériens ou en orbite. Interesting Engineering :https://interestingengineering.com/innovation/new-wireless-power-record-beaming |  |  |  |

| |  |  |

À première vue, leur expérience semble impossible. La cible : une simple étiquette placée à 1,36 km, soit plus de 14 terrains de foot. Une distance suffisante pour que même un très bon télescope n’y voit que flou. Une paire de jumelles ne distinguerait qu’une tache indistincte. Et pourtant, les chercheurs sont parvenus à reconstruire les lettres inscrites dessus – hautes de seulement 3 millimètres. Pour comparaison, un télescope classique ne pourrait identifier à cette distance que des détails d’au moins 42 millimètres. Autrement dit : cette technologie voit 14 fois plus précisément que l’optique classique. Ce résultat n’est pas qu’un exploit technique. C’est une rupture de paradigme : elle dépasse la limite de diffraction, cette barrière physique qui restreint la résolution des systèmes optiques traditionnels, même les plus perfectionnés. Là où l’optique s’arrête, le laser entre en scène. Mais comment cette technologie fonctionne-t-elle exactement ? Tout repose sur un principe avancé appelé interférométrie d’intensité active. Plutôt que d’essayer de “voir” directement un objet en captant sa lumière comme le fait un télescope, ce système éclaire la cible avec huit faisceaux laser infrarouges. Ces lasers illuminent la surface, comme un scanner invisible. Ensuite, deux télescopes situés à distance capent la lumière renvoyée – non pas sous forme d̵ 7;image, mais comme une signature lumineuse fluctuante. Ce que les capteurs enregistrent n’est donc pas une photo, mais une variation complexe d’intensité lumineuse, comme un code. C’est là que l’algorithme de reconstruction entre en jeu. À partir de ces signaux bruts, le système parvient à reconstruire une image nette de l’objet, révélant des détails invisibles à l’œil nu à cette distance. En plus de repousser les limites physiques de l’optique, cette méthode présente un autre avantage de taille : elle est beaucoup moins sensible aux perturbations atmosphériques. Les turbulences de l’air, la chaleur, la poussière ou les micro-gouttelettes d’humidité peuvent facilement dégrader l’image obtenue par un appareil photo ou un télescope. Mais ici, comme l’image est reconstruite à partir de données dynamiques et corrélées, les distorsions sont en grande partie filtrées. C’est comme si l’on observait à travers l’atmosphère avec des "lunettes correctrices numériques". On pourrait croire que cette technologie servira uniquement à des missions de surveillance ou de renseignement. Certes, ses applications militaires sont évidentes — observer une cible à distance, lire une plaque, ou surveiller un site stratégique sans drone ni caméra embarquée. Mais les chercheurs ont bien plus en tête. Dans l’archéologie, par exemple, ce système pourrait permettre de lire des inscriptions gravées à flanc de falaise sans risquer la vie des chercheurs. En écologie, il pourrait surveiller des nids d’animaux menacés, sans s’approcher ni les perturber. En industrie, il pourrait inspecter des structures à distance — sur une ligne à haute tension, un pont inaccessible, ou une installation chimique dangereuse. Bien sûr, tout cela est encore en phase expérimentale. Le système actuel est encombrant, dépend d’un alignement parfait entre lasers et capteurs, et ne fonctionne bien que dans des conditions optimales : pas de brouillard, pas d’obstacles, et une bonne capacité de réflexion lumineuse de la cible. Mais les chercheurs sont déjà à pied d’œuvre pour miniaturiser le système, le rendre plus robuste, et surtout, y intégrer l’intelligence artificielle pour qu’il s’adapte automatiquement aux conditions d’observation et améliore encore la reconstruction des images. Leur but ? Créer une version portable, qui tiendrait dans une valise et fonctionnerait de manière autonome. Une sorte de "super œil numérique" que l’on pourrait emmener partout. Si la miniaturisation suit, si l’IA tient ses promesses, alors cette technologie pour rait changer notre rapport à la vision — tout comme le microscope l’a fait il y a 400 ans, ou la caméra infrarouge il y a 50 ans. Science et Vie : https://www.science-et-vie.com/technos-et-futur/defense/dechiffrer-des-lettres-d... |  |  |  |

| |  |  |

Jusqu'à présent, les matériaux ne peuvent atteindre la supraconductivité qu'à des températures extrêmement basses, proches du zéro absolu. Mais des chercheurs américains du Caltech ont découvert un nouvel état supraconducteur, soit un nouveau type de comportement que peuvent adopter les matériaux. Pour comprendre en quoi cette découverte représente une pièce importante du puzzle, il faut savoir comment fonctionne le principe de la résistance électrique dans les supraconducteurs. Dans les matériaux dits “normaux”, les électrons individuels entrent en collision avec des ions lorsqu'ils se déplacent à travers la structure cristalline du métal. Chaque collision fait perdre de l'énergie aux électrons, augmentant la résistance électrique. En revanche, dans les matériaux supraconducteurs, les électrons sont faiblement attirés les uns vers les autres et peuvent se lier, formant des duos appelées paires de Cooper. Ces électrons appariés restent dans une plage d'énergie spécifique et relativement petite, appelée la "fente d'énergie". Tant que les électrons restent dans cette plage, ils ne perdent pas d'énergie lorsqu'ils interagissent avec les autres particules. C’est dans cette fente d’énergie que la supraconductivité se produit. La découverte de l’équipe de recherche repose sur plusieurs décennies de recherches. Contrairement à ce que l’on pensait avant, dans les années soixante, les scientifiques suggèrent que la fente d’énergie pourrait être plus forte dans certaines zones du matériau supraconducteur. Dans les années 2000, une nouvelle idée émerge : dans certains matériaux supraconducteurs, la fente d'énergie ne serait pas uniforme, mais fluctuerait de manière périodique. Cette fluctuation, qui se produit sur une longue longueur d'onde, pourrait influencer de manière significative la manière dont la supraconductivité se manifeste. Les chercheurs ont appelé cela un "état de densité d'ondes de paires" (PDW). Aujourd’hui, l’équipe de recherche dirigée par Steven Nadj-Perge, chercheur au California Institute of Technology, a décidé d’explorer la fente d’énergie en étudiant des flocons très fins d’un supraconducteur à base de fer : le FeTe0.55Se0.45. Ils ont utilisé une technique de microscopie à effet tunnel, qui permet d'examiner la surface d'un matériau à l'échelle atomique. Cette méthode n’avait pas pu être réalisée auparavant à cause de problèmes de contamination de la surface. En réussissant à obtenir une surface propre, ils ont découvert que la fente d'énergie dans ce matériau ne restait pas constante, mais se modulait régulièrement sur des distances aussi petites que l'espacement entre les atomes, avec des variations atteignant jusqu’à 40 %. Cette modula tion appelée "modulation de densité des paires de Cooper (PDM)", représente la plus forte modulation observée à ce jour. Enfin, les chercheurs ont proposé un modèle expliquant cette modulation, suggérant qu'elle provient de ruptures dans les symétries du matériau, spécifiques aux flocons fins étudiés. Cette découverte permet aux chercheurs de mieux comprendre les mécanismes sous-jacents de la supraconductivité et ouvre la voie à des avancées potentielles pour développer des matériaux supraconducteurs plus performants, notamment à température ambiante. Nature : https://www.nature.com/articles/s41586-025-08703-x |  |  |  |

| |  |  |

Une équipe de chercheurs de l’Institut Fraunhofer pour les systèmes énergétiques solaires ISE et de l’Université de Fribourg, a mené, pendant trois ans, une étude approfondie sur les effets de trois installations photovoltaïques flottantes situées sur des lacs artificiels. Cette étude, conduite dans le cadre du projet "FPV4Resilience", visait à évaluer l’impact environnemental de ces systèmes sur la qualité de l’eau et la biodiversité aquatique. Les résultats montrent qu’aucune détérioration significative de la qualité de l’eau n’a été observée, malgré les différences de conception et de taille des trois installations. Les scientifiques ont constaté de légères variations de température de l’eau : en été, la présence des modules photovoltaïques réduit le réchauffement de la surface, tandis qu’en hiver, elle limite les pertes de chaleur, maintenant des températures légèrement plus élevées. Ces effets ont été particulièrement notables sur le site de Sekdoorn aux Pays-Bas, qui abrite la plus grande des trois installations étudiées, exploitée par BayWa r.e. Deux des installations ont vu l’apparition de colonies de moules sur leurs structures immergées. Bien que la respiration de ces organismes réduise localement la concentration en oxygène dans l’eau, leur présence contribue à filtrer cette dernière et à fixer le phosphore, jouant ainsi un rôle écologique bénéfique. Les chercheurs soulignent toutefois que d’autres facteurs, souvent liés à l’activité humaine, peuvent avoir un impact plus marqué sur les plans d’eau, notamment sur les niveaux d’oxygène dans l’eau, que les systèmes photovoltaïques eux-mêmes. Cela illustre la complexité des interactions entre usages économiques, biodiversité et technologies flottantes. L’étude a également révélé que la faune aviaire ne manifeste aucune réticence à ; l’égard des installations. Sur le site néerlandais de Sekdoorn, vingt-cinq espèces d’oiseaux ont été recensées, dont onze directement sur la structure flottante. Parmi elles, des espèces rares comme le vanneau huppé et la bécassine. Les oiseaux utilisent les installations comme lieux de repos, de nidification ou de chasse. Les trois sites étudiés se trouvent dans des contextes climatiques et géographiques variés. Le premier est le lac des Toules en Suisse. Le second est situé à Leimersheim, en Allemagne. Le troisième se trouve à Sekdoorn, aux Pays-Bas, sur une ancienne gravière exploitée par BayWa r.e.. Ces installations, mises en service entre 2019 et 2021, sont implantées sur des retenues hydroélectriques ou des sites d’extraction reconvertis. BayWa r.e. a obtenu en France des autorisations administratives pour la construction de son parc photovoltaïque flottant à Dordives (Loiret), après 5 années de développement. Ce projet innovant, implanté sur une ancienne carrière, sera prochainement candidat à un appel d’offres de la Commission de régulation de l’énergie (CRE). Le chantier devrait débuter à l’hiver 2027, pour une mise en service prévue au premier trimestre 2028. Ce sera le premier parc solaire flottant de BayWa r.e. construit en France. Le projet prévoit l’installation d’environ 34 000 panneaux solaires flottants sur un plan d’eau d’environ 15 hectares, au sein de la carrière de granulat du Nançay, anciennement exploitée par Lafarge Holcim. D’une puissance d’environ 14 MWc, le parc produira chaque année 15 GWh d’électricité renouvelable, soit l’équivalent de la consommation domestique de 3 200 foyers, couvrant ainsi l’ensemble des besoins des habitants de Dordives. Enerzine : https://www.enerzine.com/les-installations-photovoltaiques-flottantes-pourraient... |  |  |  |

| |  |  |

Des chercheurs japonais de l’Agence japonaise pour les sciences et technologies marines et terrestres (JAMSTEC) ont imaginé un matériau inédit : le tPB. Ce carton transparent biodégradable se présente comme une alternative au plastique classique. Le tPB est fabriqué à partir de cellulose vierge ou recyclée grâce à un procédé qui dissout puis coagule cette matière. Sa transparence le rend parfait pour des applications visuelles et marketing. Sous la houlette de Noriyuki Isobe, une technique innovante utilisant du bromure de lithium a été mise au point pour produire ce matériau, en se passant de coagulants chimiques potentiellement nocifs. Une fois la solution séchée, le tPB se transforme en une matière rigide, capable de former des structures tridimensionnelles épaisses. Par exemple, un gobelet fabriqué en tPB peut contenir de l’eau bouillante pendant plus de trois heures grâce à un revêtement spécial à base de sel d’acide gras végétal qui le rend totalement étanche. Le tPB ne se contente pas d’être biodégradable, il est aussi recyclable, grâce à une méthode innovante qui permet de préserver ses qualités écologiques. Dans les abysses océaniques, il se décompose en environ 300 jours et bien plus vite dans les eaux moins profon des. Même si son recyclage peut légèrement altérer sa transparence, ses autres qualités écologiques restent intactes. En parallèle, une autre équipe japonaise a mis au point un plastique biodégradable résistant qui se dissout entièrement en moins de neuf heures dans l’eau salée, sans laisser de traces de microplastiques. Science : https://www.science.org/doi/10.1126/sciadv.ads2426 |  | | ^ Haut |  |

|

|  | | Vivant |  |

Santé, Médecine et Sciences du Vivant |  |

|  | | |  |  |

La consommation de caféine fait partie du quotidien de nombreuses personnes à travers le monde, mais ses effets sur notre organisme dépassent le simple coup de fouet matinal. Une étude publiée en 2023 a établi des liens significatifs entre les niveaux de caféine dans le sang, la masse graisseuse corporelle et le risque de diabète de type 2. Ces découvertes pourraient transformer notre perception des boissons caféinées sans calories comme outils potentiels de gestion du poids et de prévention des maladies métaboliques. L'étude menée conjointement par l'Institut Karolinska en Suède et des chercheurs britanniques des universités de Bristol et Imperial College London a révélé des associations génétiques importantes. Les participants présentant des concentrations plasmatiques de caféine plus élevées ten daient à afficher un indice de masse corporelle (IMC) et une masse grasse totale inférieurs à la moyenne. Les chercheurs ont analysé les données génétiques d'environ 10 000 personnes, en se concentrant sur les variations des gènes CYP1A2 et AHR. Ces gènes jouent un rôle crucial dans la métabolisation de la caféine. Les porteurs de certaines variations génétiques décomposent la caféine plus lentement, ce qui prolonge sa présence dans le sang malgré une consommation généralement moindre. Pour établir ces liens, les scientifiques ont utilisé la randomisation mendélienne, une technique permettant d'identifier des relations causales probables entre facteurs génétiques et résultats cliniques. Cette approche a permis de contourner certaines limites des études observationnelles classiques. L'un des résultats les plus marquants de cette recherche, dont les travaux ont été publiés dans BMJ Medicine, concerne l'association entre la caféine dans le sang et le diabète de type 2. Les données indiquent que des concentrations plus élevées de caféine dans le sang s'accompagnent d'un risque réduit de développer cette maladie métabolique chronique. Plus précisément, les chercheurs estiment qu'environ la moitié de l'effet protecteur de la caféine contre le diabète s'explique par son impact sur la réduction de l'IMC. Ces résultats s'inscrivent dans la continuité d'études antérieures ayant déjà suggéré qu'une consommation modérée de caféine pouvait améliorer la santé cardiaque et favoriser un IMC plus bas. Compte tenu de la consommation mondiale massive de caf éine, même ses effets métaboliques modestes pourraient avoir des implications importantes pour la santé publique. Les chercheurs suggèrent que les boissons caféinées sans calories méritent d'être cherchées comme stratégies potentielles d'intervention pour réduire le fardeau global de l'obésité et du diabète. BMJ : https://bmjmedicine.bmj.com/content/2/1/e000335 |  |  |  |

| |  |  |

Une étude Sud-Coréenne portant sur plus d'un million de personnes a montré que les personnes vaccinées contre le zona présentent un risque réduit de 23 % d'événements cardiovasculaires, notamment d'accidents vasculaires cérébraux, d'insuffisance cardiaque et de maladies coronariennes. Malgré l'association potentielle entre le zona et les événements cardiovasculaires, peu d'études ont examiné la relation entre la vaccination (avec un virus vivant) et les résultats cardiovasculaires. Cette étude de cohorte à grande échelle, basée sur la population et avec un suivi à long terme, a étudié l'association entre la vaccination contre le zona et le risque de divers événements cardiovasculaires. L'étude a été dirigée par le Professeur Dong Keon Yon de la faculté de médecine de l'université Kyung Hee, à Séoul (Corée du Sud). « Le zona provoque une éruption cutanée douloureuse et peut entraîner de graves complications, en particulier chez les personnes âgées et celles dont le système immunitaire est affaibli. Des recherches antérieures ont montré qu'en l'absence de vaccination, environ 30 % des personnes peuvent développer un zona au cours de leur vie. Outre l'éruption cutanée, le zona a été associé à un risque accru de problèmes cardiaques, et nous avons donc voulu savoir si la vaccination pouvait réduire ce risque » a-t-il déclaré dans un communiqué. L'étude a porté sur 1 271 922 personnes âgées de 50 ans ou plus et vivant en Corée du Sud. Les chercheurs ont recueilli des données, à partir de 2012, sur la vaccination contre le zona et les ont combinées avec des données sur leur santé cardiovasculaire et des données sur d'autres facteurs pouvant influencer la santé, tels que l'âge, le sexe, la richesse et le mode de vie. Il s'agissait dans cette étude d'un vaccin dit vivant atténué, c'est-à-dire qu'il contenait une forme affaiblie du virus de la varicelle et du zona, responsable du zona. Précisons que dans de nombreux pays, y compris la France, ce type de vaccin est désormais remplacé par un vaccin non vivant, recombinant, c'est-à-dire contenant une protéine du virus de la varicelle et du zona. L'étude a montré que chez les personnes ayant reçu le vaccin, le risque d'événements cardiovasculaires était globalement réduit de 23 %, avec un risque réduit de 26 % d'événements cardiovasculaires majeurs (accident vasculaire cérébral, crise cardiaque ou décès dû à une maladie cardiaque), un risque réduit de 26 % d'insuffisance cardiaque et un risque réduit de 22 % de maladie coronarienne. L'étude a par ailleurs montré que l’effet protecteur du vaccin dure jusqu'à huit ans et est particulièrement prononcé chez les hommes, les personnes âgées de moins de 60 ans et celles qui ont un mode de vie dégradé (tabagisme, consommation d'alcool, inactivité). Le Professeur Yon a déclaré : « Notre étude suggère que le vaccin contre le zona peut contribuer à réduire le risque de maladie cardiaque, même chez les personnes qui ne présentent pas de facteurs de risque connus. Cela signifie que la vaccination pourrait avoir des effets bénéfiques sur la santé au-delà de la prévention du zona. News Medical Life Sciences : https://www.news-medical.net/news/20250505/Shingles-vaccine-linked-to-lower-risk... |  |  |  |

| |  |  |

La dépression est la maladie psychiatrique la plus fréquente dans le monde. En France, elle touche environ une personne sur cinq au cours de sa vie. Cette maladie peut entraîner de nombreuses complications, au premier rang desquelles le suicide. Quand la dépression est sévère, les antidépresseurs sont recommandés comme traitement de première intention. Cependant, un tiers des patients sont résistants aux médicaments usuels. C’est pourquoi d’autres stratégies de psychiatrie ont été mises au point, dont les techniques de neuromodulation. Une publication parue dans Brain stimulation présente les résultats encourageants d’un essai clinique ouvert (sans groupe placebo) reposant sur une technologie novatrice à base d’ultrasons. Cette méthode vise à stimuler les régions au milieu du cerveau où il y a un carrefour des réseaux neuronaux liés aux troubles psychiatriques. David Attali est psychiatre et chercheur à l'hôpital Saint-Anne (Université Paris-Cité) et co-auteur principal de l’étude avec la chercheuse et psychiatre Marion Plaze. Il explique que « la seule façon d’aller stimuler ces régions profondes jusqu’ici, c’était au cours d'une neurochirurgie sous anesthésie générale, durant laquelle on allait implanter une électrode ». Cette pratique de stimulation cérébrale profonde invasive (DBS, pour deep brain stimulation), peut se révéler très efficace, mais elle s'accompagne de potentiels risques d'infection ou d'hémorragie. Cette neurochirurgie était finalement réservée à un nombre très limité de patients chaque année, « il y avait une incohérence entre la faible capacité de dissémination de cett e technique et les chiffres stratosphériques de la dépression », renchérit David Attali. Dans leur publication, les neuroscientifiques présentent la stimulation transcrânienne par ultrasons de faible intensité (TUS, pour transcranial ultrasound stimulation). « Ce sont des ultrasons comme ceux qui sont utilisés lors des échographies obstétricales pour les femmes enceintes », illustre David Attali. Pour la première fois, de façon très précise et non-invasive, la TUS permet d’atteindre les régions profondes du cerveau, dont celles impliquées dans la dépression. Depuis l’invention de l’imagerie par résonance magnétique (IRM) dans les années 1970, les techniques d’imagerie cérébrale ont considérablement progressé. Désormais, les psychiatres connaissent de mieux en mieux les structures du cerveau impliquées dans la dépression. « Pour les cinq patients inclus da ns notre étude, nous avons stimulé une région du cerveau qui s'appelle la région cingulaire subcalleuse », explique David Attali. « Elle est située à peu près à six centimètres de profondeur et visible sur des IRMs poussées où toutes les fibres de la matière blanche du cerveau sont reconstruites ». Pour chaque patient, la localisation de la zone ciblée est déterminée sur mesure avec une longue IRM une semaine avant le traitement par ultrasons. Leur état de santé générale et psychiatrique est également évalué. Ensuite, les patients sont traités avec plusieurs séances de cinq minutes, sur cinq jours consécutifs, à l’aide d’ultrasons de faible intensité. Les séances sont réparties sur une journée et espacées d’une heure environ. Après les cinq jours de traitement, une autre IRM du cerveau est réalisée ainsi que des tests psychiatriques. En moyenne, au cinquième jour de traitement, la sévérité de la dépression a été réduite de 61 % – chiffre calculé avec l’échelle MADRS (pour Montgomery-Åsberg Depression Rating Scale), reconnue dans la communauté médicale. Le traitement n’a pas provoqué d'effets indésirables graves : « les patients ne se plaignaient d'aucune gêne ni douleur pendant les séances ». C’est la première application chez l'humain des ultrasons aidés de lentilles acoustiques, pour stimuler de façon non-invasive les régions profondes du cerveau avec autant de précision. Selon David Attali, « les patients étaient incapables de nous dire quand les ultrasons étaient émis ou pas », un point important pour contrôler l’effet placebo dans de futures recherches. Par cet aspect, la TUS se différencie d’autres techniques de neuromodulation, telles que la stimulation magnétique transcrânienne (TMS). Cette dernière est fondée en effet sur l’émission d’un champ magnétique qui se convertit en électricité au croisement avec la peau, conduisant par exemple à la contraction des muscles situés sur le passage du signal (une contraction ressentie par le patient). David Attali se réjouit de ces résultats encourageants. « Nous montrons une faisabilité parfaite d’une technique simple à mettre en place. Le protocole s'est très bien déroulé et la toléra nce était très bonne. Mais ces résultats sont à prendre avec des pincettes », nuance-t-il. Le psychiatre rappelle que l’expérience n’a été menée que sur un faible nombre de patients et qu’il manque un groupe témoin (qui sera placé dans les mêmes conditions sans recevoir le traitement testé) afin de valider l’efficacité de la méthode. Les ultrasons font un véritable carton en neurosciences et cette publication montre qu’un défi a été relevé : contourner l’effet de défocalisation du crâne. En effet, la grande hétérogénéité du crâne altère la qualité du faisceau ultrasonore le traversant et induit des aberrations dans le signal, ce qui a entravé le développement des techniques utilisant des ultrasons en neurosciences durant plusieurs décennies. Pour pallier ce défaut, l’équipe de Jean-François Aubry, ingénieur-physicien au CNRS, a mis au point des lentilles acoustiques imprimées en 3D et fabriquées sur-mesure pour chaque patient. La lentille placée devant le crâne déforme l’onde ultrasonore pour contrebalancer la deuxième déformation qui aura lieu dans le crâne. La TUS aidée de ce s lentilles est l’aboutissement de vingt-cinq années de recherche sur les méthodes de focalisation des ultrasons à travers le crâne. « Grâce à la lentille acoustique développée par l’équipe de Jean-François Aubry et Mickaël Tanter, nous sommes sûrs que les ultrasons se concentrent sur une région cérébrale précisément, et non pas un centimètre à côté », s'enthousiasme David Attali. Cette invention a été élaborée à l’Institut physique pour la médecine et brevetée. La start-up SonoMind a ensuite été créée afin d’accélérer le transfert clinique de cette technologie. La Recherche : https://www.larecherche.fr/cerveau-sant%C3%A9-neurosciences/la-d%C3%A9pression-c... |  |  |  |

| |  |  |

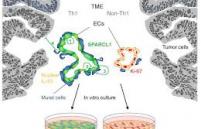

Une équipe brésilienne jette aujourd’hui une lumière nouvelle sur une molécule peu étudiée : hevin, ou SPARCL-1. Produite naturellement dans le cerveau par les cellules nommées astrocytes, cette protéine intrigue par sa capacité à soutenir la connectivité neuronale. Jusqu’ici, l’attention s’est longtemps portée sur les neurones eux-mêmes et les fameuses plaques toxiques de bêta-amyloïdes. Or, il se pourrait bien que la solution se niche ailleurs. Au cœur de ces travaux menés par des chercheurs de l’Université Fédérale de Rio de Janeiro (UFRJ) et de l’Université de São Paulo, l’équipe a choisi d’accroître artificiellement la production de hevin chez des souris – aussi bien saines qu’atteintes d’un syndrome proche d’Alzheimer. Résultat : durant six mois, ces rongeurs traités ont affiché des capacités nettement supérieures en mémoire et apprentissage face à leurs congénères non traités. Des examens du cerveau ont également mis en évidence une communication neuronale optimisée au niveau des synapses. Derrière cette amélioration cognitive, il semble que hevin active indirectement toute une cascade de protéines favorables à la santé synaptique. Preuve supplémentaire de sa pertinence : l̵ 7;analyse de données publiques a révélé des taux anormalement faibles d’hevin dans les cerveaux humains touchés par la maladie d’Alzheimer. Pour Flávia Alcantara Gomes, neurobiologiste à l’UFRJ, ce changement de perspective est capital : « L’originalité réside dans la compréhension du rôle central des astrocytes dans ce processus ». Jusqu’alors reléguées au rang d’assistantes discrètes, ces cellules gagnent un statut d’actrices majeures. De nouveaux traitements pourraient donc viser spécifiquement cet acteur cellulaire plutôt que s’acharner exclusivement sur les neurones ou les plaques. Il faut toutefois rappeler que franchir le pas entre tests sur souris et thérapies humaines nécessitera encore patience et prudence – mais pour certains scientifiques, c’est là un espoir tangible. Autre enseignement notable : augmenter l’hevin n’a eu aucun effet mesurable sur l’accumulation des fameuses plaques bêta-amyloïdes. Un point qui alimente le débat en cours sur leur véritable implication dans la pathologie. Comme le souligne Felipe Cabral-Miranda, biomédical à l’UFRJ : « L’étude prouve qu’on peut inverser le déclin cognitif sans agir sur les plaques. » De quoi remettre en cause certaines théories dominantes et ouvrir des perspectives plus larges pour comprendre – et espérer traiter – cette maladie complexe qu’est Alzheimer. Science Alert : https://www.sciencealert.com/scientists-discover-molecule-that-blocks-aging-and-... |  |  |  |

| |  |  |

Avant même la naissance, notre âge biologique est défini entre autres par la longueur des télomères. Une étude parue dans la revue Nature Communications montre que la taille de ces petites structures d’ADN, servant à protéger les extrémités des chromosomes, a un impact direct sur l’espérance de vie. Plus les années passent et plus ces cellules se divisent, réduisant ainsi de taille, jusqu’à devenir trop petite pour protéger le corps contre des maladies chroniques. C’est pourquoi plus ils sont longs à la naissance, plus ils peuvent nous protéger pendant un certain nombre d’années. « Certains bébés sont nés avec des télomères plus courts, ce qui augmente leur risque de développer des maladies chroniques en vieillissant. Par exemple, les enfants de femmes souffrant d'obésité ou d'un syndrome métabolique ont des télomères plus courts à la naissance », déclare Rebecca Robker, directrice de l’étude. Et de poursuivre : « Une fois adultes, ces personnes ont un risque accru de mortalité par maladie cardiovasculaire, même si elles ne sont pas obèses elles-mêmes ». Ainsi, la grossesse a un rôle prépondérant dans le rallongement des télomères pour le bébé. Une fois que la fécondation se produit, l’embryon possède les télomères de ses parents. Mais pour éviter que le futur nourrisson ne se retrouve avec l’âge biologique de ses géniteurs, l’embryon rallonge naturellement les télomères. Ce phénomène naturel peut toutefois être entravé par le stress. « Nos résultats montrent que la santé maternelle et les conditions environnementales au moment de la conception peuvent avoir des conséquences à long terme », explique Yasmyn Winstanley, co-autrice de l’étude. Mais il existe des traitements qui permettraient de favoriser le bon développement des télomères avant la naissance, selon les chercheurs. « Il y a des opportunités thérapeutiques pour améliorer ce processus de rallongement des télomères, qui est déterminant p our le risque de maladies chroniques », avance Rebecca Robker. Après la naissance plusieurs facteurs peuvent impacter l’espérance de vie, à l’image de l’absence d’activité physique, la cigarette ou la consommation excessive d’alcool. Nature Communications : https://www.nature.com/articles/s41467-025-57794-7 |  |  |  |

| |  |  |

Une vaste étude internationale montre que des interventions de renforcement musculaire peuvent diminuer la mortalité chez les patients atteints de cancer à stade avancé. De plus en plus d’études documentent les avantages de l’exercice, avant, pendant et après le traitement d’un cancer. Cette recherche insiste sur l’efficacité du renforcement musculaire pour faire face à la maladie et augmenter la survie. Ces données qui peuvent sembler basiques pourraient cependant modifier la vie, la survie et la qualité de vie des 20 millions de personnes dans le monde qui reçoivent, chaque année, un diagnostic de cancer. Environ 10 millions d'entre elles décèderont de leur maladie. Si les traitements ont bien progressé, leurs effets secondaires, notamment ceux qui s'exercent sur le cœur et les muscles, perdurent et ont de lourdes conséquences sur la s urvie. L’étude regarde comment la force musculaire et la capacité cardiorespiratoire sont associées à la survie chez des patients atteints de cancer et comment le type et le stade du cancer peuvent impacter ces résultats. Il s’agit d’une très large revue de la littérature médicale publiée sur le sujet, soit de 42 études sélectionnées, portant sur un total de 47.000 patients, âgés en moyenne de 64 ans et atteints de cancers de différents types et à différents stades. La force de préhension a été utilisée pour mesurer la force musculaire et un test d'exercice cardiorespiratoire et un test de marche de 6 minutes ont été utilisés pour mesurer la capacité cardiorespiratoire. La méta-analyse confirme que : la force musculaire et la forme cardiorespiratoire sont significativement associées au risque de décès toutes causes confondues et par cancer ;

vs une faible force musculaire et faible forme cardiorespiratoire, des niveaux plus élevés, « à l’autre extrémité du spectre » sont associés à une réduction de 31 à 46 % du risque de décès toutes causes ; ce risque diminuait encore de 11 % à chaque augmentation d’une unité de force musculaire ; la combinaison force et forme physique est associée à une réduction de 8 à 46 % du risque de décès toutes causes chez les patients atteints d’un cancer avancé (stades 3 et 4), et à une réduction de 19 à 41 % chez les personnes atteintes d’un cancer du poumon ou de l’appareil digestif ; chaque augmentation d’une unit&e acute; du niveau de forme physique était associée à une réduction du risque de décès par cancer de 18 %. Pris ensemble, ces résultats soulignent une fois de plus l’importance d’une bonne condition physique lors du diagnostic de cancer, pour de meilleures chances de survie, mais sensibilisent tout particulièrement à l’entretien, par l’exercice de la forme musculaire. BMJ :https://bjsm.bmj.com/content/59/10/722 |  |  |  |

| |  |  |

Selon une étude britannique, chez les personnes âgées, dépression et démence pourraient être liées. Les scientifiques avancent deux explications possibles : soit la dépression augmente le risque de souffrir de démence, soit elle en est l’un des premiers symptômes. Chez les seniors, la prévalence de la dépression est élevée. Cette maladie psychique concerne 4 à 13 % des plus de 65 ans. Les personnes qui en sont atteintes souffrent de troubles de l'humeur qui peuvent avoir des conséquences importantes sur la vie quotidienne comme la perte du sommeil, l’isolement, des troubles de l'appétit, etc. « Notre étude montre que la dépression est associée à un risque plus important de démence [chez les personnes d’âge moyen et avancé] », explique Jacob Brain, l’un des auteurs de l 8217;étude, dans un communiqué. « Cela montre l'importance de reconnaître et de traiter la dépression tout au long de la vie, non seulement pour la santé mentale, mais aussi dans le cadre d'une stratégie plus large visant à protéger la santé cérébrale ». En 2021, 57 millions de personnes dans le monde étaient atteintes de démence, selon l’Organisation mondiale de la santé (OMS). Ce terme regroupe plusieurs maladies qui affectent la mémoire, la pensée et la capacité à réaliser des tâches quotidiennes. La plus fréquente est celle d’Alzheimer. Le risque de développer une démence augmente avec l’âge chez les dépressifs. Les scientifiques ont d’abord fait une méta-analyse des études ayant traité du lien entre dépression et démence. Ensuite, ils ont extrait les meilleures données de chacun de ces travaux, les ont ré-analysées et y ont ajouté les résultats de publications plus récentes. De cette façon, ils ont découvert que la dépression chez les personnes âgées (au-delà de 65 ans) augmentait fortement - près de deux fois plus - le risque de démence, comparativement à celles qui n’étaient pas dépressives. La dépression à un âge moyen (avant 65 ans) favorisait le risque de démence, mais un peu moins, d’environ 56 %. « Nos résultats suggèrent que la dépression tardive pourrait non seulement être un facteur de risque, mais aussi un signal précoce du développement de la démence », indique Jacob Brain. « Nos travaux contribuent à orienter les futures stratégies de recherche, de traitement et de prévention (...). Les efforts de santé publique doivent davantage mettre l'accent sur la prévention de la santé cérébrale, notam ment en élargissant l'accès à des soins de santé mentale efficaces ». The Lancet : https://www.thelancet.com/journals/eclinm/article/PIIS2589-5370(25)00198-1/fulltext |  | | ^ Haut |  |

|

|

| VOTRE INSCRIPTION |  | Vous recevez cette lettre car vous êtes inscrits à la newsletter RTFLash. Les articles que vous recevez correspondent aux centres d'intérêts spécifiés dans votre compte.

Désinscription Cliquez sur ce lien pour vous désinscrire.

Mon compte pour créer ou accéder à votre compte et modifier vos centres d'intérêts.

|

| |

|

|